【爱否SEO】 > SEO技术 > seo优化技术 >

影响网站收录之:利用robots.txt 禁止不想被收录的

编辑:【爱否SEO】发布时间: 2017-12-12影响网站收录之:利用robots.txt 禁止不想被收录的url robots.txt 文件位于您网站的根目录下,用于表明您不希望搜索引擎抓取工具访问您网站上的哪些内容。此文件使用的是 Robots 排除标准,该标准是一项协议,其中含有一小组命令,用于表明哪些类型的网页抓取工具(比如移动版抓取工具与桌面版抓取工具...

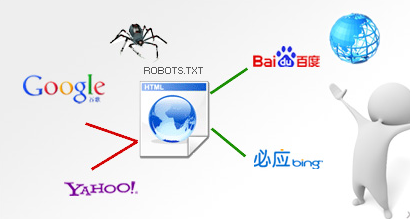

影响网站收录之:利用robots.txt 禁止不想被收录的url

robots.txt 文件位于您网站的根目录下,用于表明您不希望搜索引擎抓取工具访问您网站上的哪些内容。此文件使用的是 Robots 排除标准,该标准是一项协议,其中含有一小组命令,用于表明哪些类型的网页抓取工具(比如移动版抓取工具与桌面版抓取工具)可以访问您网站的哪些部分。

什么样的URL需要robots.txt 禁止搜索引擎蜘蛛抓取呢?

1.同时存在动态和静态URL

通常情况下很多网站都会对URL进行静态化,但是很多时候在网站的运营过程中,往往导致动态URL也被抓取了,比如营销部门不小心用动态URL来推广,比如产品部门不小心也用了动态URL,这个时候就会导致两个不一样的URL对应相同的内容,这对搜索引擎来讲是不友好的,也会导致权重的分散,或者导致搜索引擎抓取的页面不是站长需要的,这时候就需要用robots.txt来屏蔽动态的URL了。

2.有些内容我们不需要搜索引擎进行抓取

大家都知道淘宝不希望被百度抓取,淘宝认为他的商品页面最具价值,不希望百度收录之后导致用户搜索商品到来百度搜索,这样对淘宝来讲是不利益的,所以淘宝就屏蔽了百度的抓取,自然淘宝也少了很多流量。

我们有些会员信息,网站程序URL等都不希望被搜索引擎抓取,那么也可以用robots.txt进行屏蔽。

利用robots.txt 禁止不想被收录的url的好处:

1.重复的URL被屏蔽之后,有利于权重的积累

2.屏蔽一些无效的URL能提高搜索引擎的抓取效率,因为搜索引擎到网站的时间是固定的,那么如果有很多无效的URL,对于大型网站来讲,比如几千万级别的,搜索引擎花了大量的时间处理无效的URL,自然对有效的URL处理的时间就会减少,自然就会导致收录有问题。

robots.txt的撰写规则:

robots.txt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的Notepad,就可以创建和编辑它[2]。robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。百度官方建议,仅当您的网站包含不希望被搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,请勿建立robots.txt文件。

- 上一篇:影响网站收录之:改版/换域名(301)

- 下一篇:影响网站收录之:网站安全

- 12-18分享一个爱站网关键词采集挖掘工

- 12-18构建关键词词库的渠道与工具

- 12-18构建关键词词库的思路策略

- 12-17搜索引擎如何理解用户需求案例

- 12-17SEO与PHP关键词的竞争度简单分析

- 12-17了解搜索者(关键词)类型,搜索

- 12-17百度图片搜索收录展现排序基础要

- 12-17设置首选域的方法

- 12-16影响网页排名之:百度搜索Mobil

- 12-16影响网页排名之:百度搜索Mobil

- 12-16影响网页排名之:Canonical标签

- 12-15影响网页排名之:nofollow应用

- 12-15影响网页排名之:正确使用H标签

- 12-15百度网页搜索质量白皮书:内容质

- 12-15影响网站排名之:作弊

- 12-14影响搜索结果排序(排名)之:六

- 12-14提升网页排名方法之:移动搜索优

- 12-14提升网页排名方法之:应用https

- 12-14提升网页排名方法之:提升主动访

- 12-14提升网页排名方法之四:合理的锚

- 12-13提升网页排名方法之三:赢得用户

- 12-13提升网页排名方法之二:良好的内

- 12-13提升网页排名方法之一:网页标题

- 12-13提升网站收录之:利用百度抓取诊

- 12-13影响网站收录之:无限滚动

- 12-12影响网站收录之:蜘蛛IP封禁(屏

- 12-12影响网站收录之:网站安全

- 12-12影响网站收录之:利用robots.txt 禁

- 12-12影响网站收录之:改版/换域名(

- 12-12影响网站收录之:规范、简单的

- 12-11提升网站收录方法之五:利用站长

- 12-06SEO是什么意思?SEO(搜索引擎优化

- 12-17了解搜索者(关键词)类型,搜索

- 12-17百度图片搜索收录展现排序基础要

- 12-16影响网页排名之:百度搜索Mobil

- 12-18构建关键词词库的思路策略

- 12-07《SEO实战密码》作者ZAC给SEO人员的

- 11-30网站内容页面的优化技术

- 12-14提升网页排名方法之:应用https

- 12-13提升网站收录之:利用百度抓取诊

- 12-10阿里云ECS云服务器绑定新目录的操

- 12-09利用logrotate对阿里云ECS nginx服务器

- 12-14提升网页排名方法之:移动搜索优

- 12-06学习SEO,也学禅

- 12-07国内的重要网络推广平台有哪些

- 12-09如何修改阿里云服务器密码(Se

- 12-14提升网页排名方法之:提升主动访

- 12-15影响网站排名之:作弊

- 12-12影响网站收录之:网站安全

- 12-06一盆绿萝引发的SEO思考

- 12-16影响网页排名之:Canonical标签

- 12-09阿里云ECS服务器购买使用新手指南

- 12-13提升网页排名方法之三:赢得用户

- 12-12影响网站收录之:利用robots.txt 禁

- 12-10提升网站收录方法之三:机器可读

- 12-06如何进一步提升SEO技能,突破现有

- 12-065年迷茫的SEO该怎么做?改退出转

- 12-05学习的梦想,送给刚入行的SEO工程

- 12-04关于如何学习SEO,不积硅步无以至

- 12-05新手如何开始实践SEO

- 12-15影响网页排名之:nofollow应用

- 12-08关于购买服务器和空间租用的一些

- 11-30网站内容页面的优化技术

- 12-10提升网站收录方法之四:网站结构

- 12-08利用百度site app轻松快速建设手机

- 12-09阿里云推荐码限量开放,购买EC

- 12-13提升网页排名方法之三:赢得用户

- 12-14提升网页排名方法之:应用https

- 12-17SEO与PHP关键词的竞争度简单分析

- 12-08网站建设如何选择程序

- 12-06一盆绿萝引发的SEO思考

- 12-065年迷茫的SEO该怎么做?改退出转

- 12-07网站优化(SEO)怎么做,三个方向

- 12-05互联网+意味着更多的SEO机会

- 12-13提升网页排名方法之一:网页标题

- 12-12影响网站收录之:网站安全

- 12-07SEO出现的大约时间以及SEO的类型

- 12-07阿里国际站资深总监付必鹏谈SE

- 11-29网站内容优化几大方法

- 12-18构建关键词词库的思路策略

- 12-13提升网页排名方法之二:良好的内

- 12-15百度网页搜索质量白皮书:内容质

- 12-04关于如何学习SEO,不积硅步无以至

- 12-06学习SEO,也学禅

- 12-14提升网页排名方法之:提升主动访

- 12-05搜索引擎的未来

- 12-17了解搜索者(关键词)类型,搜索

- 12-14提升网页排名方法之四:合理的锚

- 12-09利用logrotate对阿里云ECS nginx服务器

- 12-11影响网站收录之:子域名与目录的

- 站内导航

-